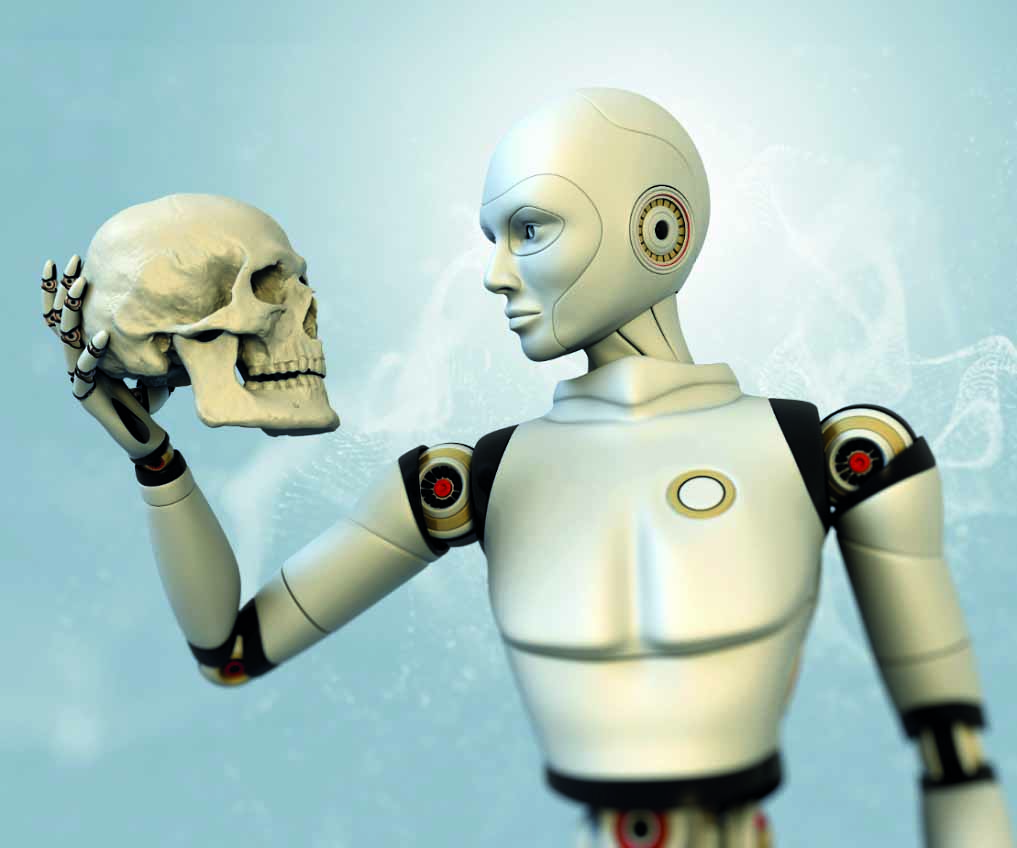

La machine s’emballe et menace d’échapper au contrôle de ses propres créateurs. Cet inépuisable script de l’imaginaire science-fiction serait-il en train d’inspirer la réalité ? La rapidité avec laquelle se développent les logiciels et usages de l’intelligence artificielle (IA), faisaient déjà des sceptiques et des inquiets, pas forcément technophobes, dans le grand public mais aussi au niveau des institutions scientifiques et politiques.

Cette fois, ce sont des experts et des opérateurs mondiaux de renom qui se mettent ensemble pour dire qu’il y a un vrai problème et qu’il faut faire quelque chose au plus vite. Un millier d’entre-eux proposent une «pause» immédiate, un moratoire de 6 mois, dans la course effrénée au développement de nouvelles générations IA, le temps que la communauté scientifique, les gouvernements et les institutions internationales puissent engager un véritable débat sur les périls encourus et les moyens de les prévenir.

«Nous risquons de perdre le contrôle sur l’avenir de notre civilisation», avertissent les signataires de la pétition d’alerte largement diffusée depuis mercredi dernier. Parmi eux, Elon Musk, patron de Tesla et de Twitter, Steve Wozniak, cofondateur d’Apple, et Andrew Yang, ex-candidat démocrate à la présidentielle américaine ainsi que de nombreux leaders scientifiques et économiques dans le domaine du numérique.

«Ces derniers mois ont vu les laboratoires d’IA s’enfermer dans une course incontrôlée pour développer et déployer des cerveaux numériques toujours plus puissants, que personne – pas même leurs créateurs – ne peut comprendre, prédire ou contrôler de manière fiable», s’effrayent-ils. Ce n’est encore une fois pas sorti d’un thriller de science-fiction, mais provient d’un beau monde qui sait de quoi il parle, et pour certains eux-mêmes impliqués dans cette incroyable révolution.

Chat-GPT, un robot qui vous veut du bien

Le lancement tout récent de la dernière version du Chat-GPT, un robot conversationnel créé par la start-up californienne OpenAi, a fini de convaincre que les choses allaient beaucoup trop vite pour que les moyens de régulation et de contrôle, déjà tâtonnants, puissent suivre et opérer. L’outil de génération de langage et de texte en est à sa quatrième version depuis novembre dernier, date de son lancement. D’autres souches de ce programme sont prévues chez OpenAi ; les concurrents également peaufinent les leurs. Google vient de lancer son Bard. Meta promet des surprises.

Chaque version propulse ces chatbot, de plus en plus accessibles au public, dans des performances qui donnent de la teneur à cette perspective de voir un jour des machines remplacer les humains. Le marché, lui, est déjà là et connaît des taux de croissance pratiquement exponentiels. Les dépenses mondiales, soit la demande publique et privée en logiciels, matériel et services pour basculer dans l’IA, atteindront 154 milliards de dollars cette année et se situeront à près de 300 milliards de dollars en 2026, selon des projections de l’International Data Corporation (IDC) publiées le 7 mars dernier.

Le Chat-GPT, pour l’heure le plus populaire (plus de 100 millions d’utilisateurs en deux mois) parmi ses concurrents chez Google, Microsoft et autres firmes et start-up, produit de la prose, des rapports techniques, peut faire un devoir à la place d’un étudiant universitaire ou un lycéen, écrire des poèmes ou des codes informatiques… Le phénomène a d’ailleurs fait sa vague dans les universités algériennes comme partout dans le monde, selon le degrés d’accessibilité, et beaucoup d’étudiants avouent y avoir recours pour rédiger des devoirs non surveillés.

Un député français a même demandé, il y a une dizaine de jours, de rédiger, pour lui, un amendement à déposer dans le cadre d’un projet de loi traitant, entre autres, de la surveillance par des caméras dites intelligentes durant les compétitions sportives. Le député voulait bien entendu alerter sur les dangers associés aux IA, qui «peuvent permettre le meilleur comme le pire».

Mais plus sérieusement, le potentiel génératif pour des usages professionnels, complets et autonomes de ces formidables outils est pratiquement illimité. Et c’est ce qui donne froid dans le dos. Selon une étude de la banque Goldman Sachs, 300 millions d’emplois à temps plein sont potentiellement menacés par des IA génératives, pour ne parler que de l’Europe et des Etats-Unis. Sur le Vieux continent, les postes les plus exposés au remplacement sont les fonctions administratives (45%), les cadres et les métiers qualifiés (34%), les techniciens (31%) et les postes de direction (29%).

Le plus grand des «grands remplacements»

En Chine, on est déjà passé à l’acte. Un «dirigeant numérique» vient d’être placé à la tête d’une importante entreprise de production de jeu vidéo. Tang Yu, madame la PDG, est une femme robot reliée à l’intelligence artificielle, elle travaille 24 heures sur 24. Cet exemple, d’apparence anecdotique, comporte une part de marketing pour la boîte, certes, mais l’option pour des investissements plus structurels dans les performances promises par les IA génératives tend à devenir stratégique.

En Allemagne, le groupe de médias Axel Springer, le plus important du pays, a annoncé, il y a un mois, des emplois en moins dans deux de ses journaux, convaincu que l’intelligence artificielle pouvait désormais «remplacer» les journalistes. «L’intelligence artificielle va révolutionner le journalisme et l’industrie des médias, en soutenant – ou remplaçant le journaliste», prédit le dirigeant du groupe Mathias Döpfner.

Il restera quand même une petite marge au journaliste humain dans l’affaire, rassure-t-il. «La création journalistique», soit les reportages, la recherche d’information ou les éditoriaux, resteront aux mains des journalistes tandis que ce qui réclame moins de valeur ajoutée sera de plus en plus automatisé. Pour le moment.

D’autres tempèrent également les prévisions et parient que les robots ne pourront jamais remplacer le bon vieil être humain sur énormément de vocations et de tâches, et qu’en termes de fiabilité, la machine montre des limites dues à son essence même.

Les algorithmes générateurs de contenus, appelés aussi réseaux neuronaux artificiels, sont basés sur le principe de l’apprentissage approfondi (Deep Learning), soit l’absorption de toutes les données disponibles sur le Net concernant un sujet ou un thème précis, pour le reproduire en texte ou mener conversation, selon la demande. Aussi, il n’est pas rare que des données initialement fausses, en circulation sur la Toile, puissent être reproduites en bonnes réponses par l’IA.

Si cette faille rassure sur l’exclusivité de certaines facultés de l’intelligence humaine, du moins jusqu’à cette phase-là de développement, c’est aussi le motif d’une autre anxiété concernant le potentiel toxique de l’IA : la diffusion à grande échelle du faux savoir et des fake news.

La nouvelle ère des fake news

Depuis peu, les IA sont passées à plus sensible, la génération d’images à la demande. Des photos d’Emmanuel Macron en plein milieu de manifs parisiennes contre la réforme des retraites, de Trump aux prises avec des policiers dans des scènes improbables, ou alors celle montrant le pape, en défilé de mode, dans sa superbe doudoune blanche… Ces documents, aussi amusants que bluffants, sont le produit d’IA génératives. Selon des sondages en ligne, la moitié des internautes les ayant visionnées ne se sont pas rendus compte que c’était des fakes.

Tout le monde doit se rappeler de la fameuse image hyper-virale du pompier grec serrant dans ses bras un enfant turc qu’il vient de retirer sain et sauf des décombres, lors du séisme de février dernier. Mais ce n’est pas tout le monde qui s’est rendu compte que la photo n’est pas une vraie, mais une production d’un générateur d’image IA. Des reproductions moins destinées au fun, dans un objectif de manipulation politique par exemple, seraient tranquillement passées comme authentiques.

Aujourd’hui, il s’agit de taper une description textuelle de contexte, de lieu, d’identité de personnages, sans aucune compétence poussée, pour que les outils de l’AI générative crée l’illustration (photo, dessin, peinture…). Midjourney, la plateforme la plus performante du moment, celle-là même qui a généré les photos virales citées plus haut, en est à sa cinquième version depuis le 15 mars dernier.

Chaque trois mois pratiquement, une nouvelle version est proposée aux utilisateurs, plus puissante et plus «professionnelle» que les précédentes. «Je ne pense pas que la société est prête à faire face à cette puissance-là, au potentiel de manipulation, par exemple, des populations qui pourraient mettre en danger les démocraties», avertit Yoshua Bengio, véritable autorité de l’IA au Canada, également signataire de la pétition.

«Devons-nous laisser les machines inonder nos canaux d’information de propagandes et de mensonges ? Devrions-nous automatiser tous les emplois, y compris ceux qui sont gratifiants ? Devons-nous développer des esprits non humains qui pourraient un jour être plus nombreux, plus intelligents, et nous remplacer ?» est-il encore écrit dans la tribune des experts. Et non, ce n’est pas de la science-fiction.

Des cadres éthiques difficiles à mettre en œuvre

Au lendemain de «la lettre ouverte» publiée par la centaine d’experts sur les dangers de l’intelligence artificielle (IA), l’Unesco a appelé les Etats à appliquer sa recommandation éthique datant de 2021, afin d’encadrer l’usage de ces outils et en contenir les risques. «Le monde a besoin de règles éthiques pour l’intelligence artificielle : c’est le défi de notre temps. La recommandation de l’Unesco sur l’éthique de l’IA définit le cadre normatif approprié», a assuré, jeudi dernier, la directrice générale de l’organisation onusienne, dans un communiqué. Les 193 Etats membres avaient adopté, en novembre 2021, un «premier cadre normatif mondial pour une utilisation éthique de l’IA», une «feuille de route pour les pays, qui décrit comment amplifier les avantages de l’IA tout en réduisant les risques que cette technologie comporte». Fruit d’un long travail d’experts, le texte série des actions à mener, notamment la mise en place d’un cadre législatif pour encadrer et surveiller les IA, «assurer une sécurité totale pour les données personnelles et sensibles» ou encore éduquer les masses à leur sujet. «L’autorégulation de l’industrie n’est manifestement pas suffisante pour éviter des préjudices éthiques», constate l’Unesco. L’UE, pour sa part, même très intéressée économiquement et pour des enjeux d’influence liés à la géopolitique du numérique, notamment vis-à-vis de la Chine, s’inquiète pour sa part des conséquences d’usages débridés des I A. Des 2021, l’Europe a lancé son propre projet de régulation, baptisé «AI Act». Le projet revient à la surface depuis janvier dernier, après le succès foudroyant du joujou de la firme OpenAi, Chat-GPT. Les pays de l’UE, un des plus gros potentiels de demande sur le marché, intéressent au plus haut point les grands producteurs de l’industrie, qui redoutent désormais des perspectives moins profitables avec ce sursaut pour un contrôle éthique sur l’activité.

L’Italie, elle, n’a pas attendu l’aboutissement du projet. Depuis ce week-end, elle est le premier pays occidental à interdire l’utilisation de Chat-GPT. L’Autorité italienne de protection des données personnelles accuse le robot conversationnel de ne pas respecter la réglementation européenne et de ne pas vérifier l’âge des usagers mineurs. L’absence d’une procédure d’information à l’égard des utilisateurs, dont les données sont récoltées par OpenAi, et «l’absence d’une base juridique justifiant le recueil et la conservation en masse des données personnelles, dans le but d’ ‘‘entraîner’’ les algorithmes faisant fonctionner la plateforme», sont les autres griefs que l’organisme italien juge éliminatoires.